全文共7355字,预计阅读时间17分钟

作者 | 程韫韵(Emily)

编辑 | 谭舒雯(Poppy)

注:文中图片均来源于网络

前言

AI芯片可分为通用计算芯片和专用神经网络计算芯片,前者主要有CPU、GPU和FPGA。CPU领域主要有为PC服务器提供高性能计算的Intel和专注于移动与嵌入式领域低功耗芯片的ARM;GPU领域的主要玩家是NVDIA和AMD,其中NVDIA在AI服务器市场占约70%的份额;FPGA领域主要有Xilinx和被Intel收购的Altera。

专用神经网络计算芯片ASIC根据支持的算法,可分为支持人工神经网络的深度学习加速器芯片和支持神经动力学的神经形态芯片。前者玩家众多,例如Google、GraphCore、寒武纪等,芯片性能各有千秋。神经形态芯片根据实现方式可分为数字芯片、模拟芯片和新材料芯片。数字芯片主要有IBM的TrueNorth、Intel的Loihi和曼彻斯特大学的SpiNNaker;模拟芯片主要有斯坦福大学的Neurogrid、欧盟的BrainScales和苏黎世大学的ROLLS;新材料芯片主要是由Memristor组成的阵列。截至2018年底,全球ASIC芯片在AI芯片市场的占有率超过10%,据Ovum预测,2025年这一数字将达到50%[1]。

人工神经网络(Artificial Neural Network)算法是目前主流的AI算法,其中最具代表性的就是深度学习算法。2006年,Geoffrey Hinton将单层受限玻尔兹曼机堆栈成多层深度信念网络(Deep Belief Network),并提出了无监督逐层贪婪预训练算法,再结合全局有监督BP算法进行微调,使得七层以上神经网络训练得到收敛。因此,2006年被认为是“深度学习元年”,Hinton成为“深度学习之父”。2011年,不连续可导的ReLU激活函数替代了连续可导激活函数如Sigmoid激活函数,从而抑制了深层网络训练梯度消失问题,让网络得以进一步加深。2012年,Hinton的学生Alex Krizhevsky提出AlexNet,第一次使用八层的CNN网络,并在当年ImageNet图像识别大赛中取得冠军。接下来几年,图像识别大赛中算法识别率不断提高,2015年ResNet的识别率已高于人眼识别率,达到了96.43%。随着人工神经网络深度的逐渐增加,网络结构越来越复杂,性能也不断提高。在不同应用领域中,深度学习算法还可以融合不同网络或传统算法来解决更高难度问题。

随着深度学习算法的不断发展,它的固有缺陷也愈发明显。例如,曾经效果显著的增加网络深度和宽度的方法,无法使性能再得到提升,图像识别领域的误识率也没有明显降低。因此,以神经动力学为代表的其他算法领域逐渐进入研究人员的视野。神经网络的发展历经了第一代前馈神经网络(Feedforward Neural Network)和第二代反向传播(Back Propagation)神经网络,在多个领域实现了突破,但在生物学上仍是不精确的,无法模仿生物大脑神经元的运作机制。神经动力学算法中,脉冲神经网络(Spiking Neural Network)属于第三代神经网络,融合了神经元、突触状态,以及时间概念,从而可以实现更高级的生物神经模拟水平。

从ANN到SNN

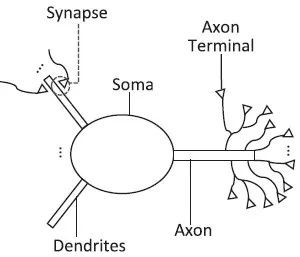

图1 生物神经元图示

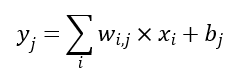

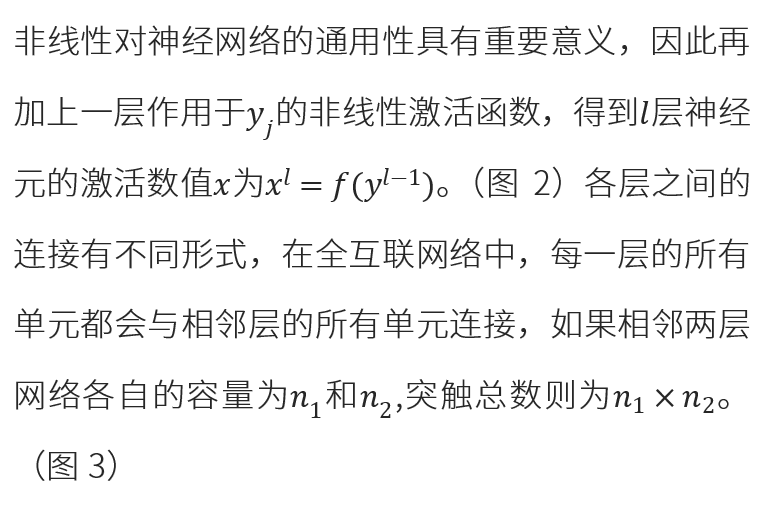

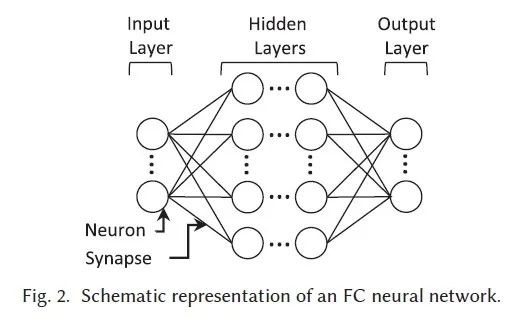

ANN(Artificial Neural Network,人工神经网络)是通过模仿生物神经网络的连接特征,结合优化算法,实现的一种用数据训练的方式寻找相对最优解的计算模型。ANN仅有限地借鉴了生物神经网络的网络拓扑结构和非线性激活的特性,而数学性更强。ANN可以看作是一个由大脑的工作机理(图1)衍生而来的多层感知器,包含一系列的基本计算单元,即神经元和突触。神经元组成的各层网络由突触相连,连接方式与网络拓扑学有关。突触后神经元结合相应的突触权重(突触效能),对从突触前神经元传来的数值进行计算,再加上一个偏置项,即

![]()

![]()

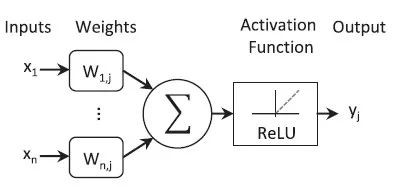

图2 非线性感知器图示

图3 全互联神经网络图示

深度学习虽然具有一定的通用性,可以解决不同领域的问题,但离通用人工智能还相差甚远。深度学习的应用场景必须满足五个条件:具有丰富的数据或知识、完全信息、确定性信息、静态或按确定性规律演化、单领域和单任务。一旦其中一个条件无法满足,深度学习应用就会受到限制。例如,自动驾驶目前还无法实现廉价可靠的解决方案,因为它不满足完全信息、确定性信息、静态环境或确定性规律演化,以及单领域的条件。因此,相比人脑,基于深度学习的AI系统在功耗、鲁棒性、推广能力、犯大错误概率、训练样本规模和可解释性等方面都存在严重缺陷。

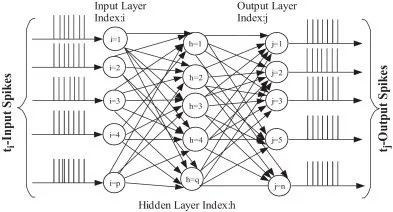

相较于ANN,SNN(Spiking Neural Network,脉冲神经网络)更接近于生物神经网络。SNN基于神经科学已有研究,通过计算模型模拟神经元生物层面的属性特征,本质上是一种仿生计算模型。SNN中脉冲电位以二进制的形式表示,使得系统能够在模拟或数字电路上可靠地运行。大多数SNN采用频率编码的形式,其中神经元间的信息传递用一个观测期内脉冲电位的平均发射速率表示。Poisson脉冲序列中虽然脉冲电位间的时间间隔是随机的,但整体发射频率不变。一些神经系统学家认为大脑信息应该用时间编码[2],如TTFS(Time to First Spike)[3]和ISI(Inter-Spike Interval)[4]模式。TTFS模式中拥有最高膜电势的神经元最先发射,而ISI模式用连续脉冲的准确延迟编码激活强度。学界也有观点认为真实的大脑信息交流过程结合了几种不同方式[5]。

![]()

图4 SNN结构图示

从连续输出到二进制输出,乍一看像是一种倒退,因为这样的脉冲序列相对来说可解释性较低。然而,脉冲序列增强了处理时空数据的能力。空间指神经元仅与附近的神经元相连,所以能够分别处理输入块,类似于CNN的滤波器。时间指脉冲序列按时间顺序发生,所以因为二进制编码丢失的信息能够在脉冲的时间信息中找回,使得时间数据能够被自然地处理,而无需 RNN添加额外的复杂度。事实证明,相较于传统人工神经元,脉冲神经元是更强大的计算单元[6]。

虽然SNN理论上比第二代网络更强大,但它的应用并不广泛。实际应用中的主要问题之一是训练,尽管有非监督学习方法如Hebbian学习和STDP,但目前没有适合SNN的有效的监督式训练方法能够提供优于第二代网络的性能。因为脉冲序列是不可微的,用梯度下降的方法训练SNN会导致脉冲序列中精确时间信息的丢失。因此,要想在现实任务中运用SNN,亟需开发有效的监督式学习方法。这是一项较困难的任务,因为涉及到了解人脑的学习机制。另一个问题是因为需要对不同的方程式进行模拟,所以在普通硬件上模拟SNN会耗费大量算力。针对这一问题,目前一些神经形态硬件能够利用神经脉冲行为的非连续性和稀疏性模拟神经元。

SNN的未来仍然不够明朗,尽管SNN是当前神经网络的自然继承者,但它与能够适用于大多数任务的实用性工具还有较远的距离[7]。目前有一些SNN在实时图像和音频处理方面的应用,如基于事件的计算机视觉研究。Intel公司的Python NxSDK-0.8.0 API使SNN能够应用在Loihi芯片上。NxNet API提供了设置神经元和突触参数的方法,例如衰减时间常数、尖峰脉冲值、突触权重和脉冲阈值等,还负责将外部刺激输入网络,执行自定义学习规则,运行时监测和修改网络。一些基于事件的计算机视觉研究将Loihi芯片接入动态视觉传感器来开发神经形态处理器[8]。针对实时推断,Loihi能够实现比传统DNN架构低五至十倍的能耗。简单的适应性脉冲模型能够实现LSTM级别高达94%的准确率,还有低时延和高吞吐量的优势,能够满足动态视觉传感器的要求。[9]

经典神经元模型

生物研究中,动作电位定时的脉冲耦合神经网络被视为大脑信息处理机制的重要部分。所有关于神经网络动力学的研究都需要解决两个主要问题:哪种模型可以描述每个神经元的脉冲动态,以及神经元间是如何相连的。根据不同的抽象程度来分,比较受到关注的脉冲神经元模型有:

Hodgkin-Huxley Model

由1963年的诺贝尔生理学或医学奖得主Alan Hodgkin和Andrew Huxley提出的HH模型是生物学上最接近大脑的模型,其中细胞膜的脂质双层结构为电容器,Na+、K+和泄漏电流的离子通道为电阻。Na+和K+离子通道的电阻会随着时间改变,而泄漏电流离子通道的电阻为常数。由于膜两侧的离子浓度差异,每种离子有一个平衡电势。如果膜电势与平衡电势相同,离子移动造成的电流值为零。当膜电位达到特定值,神经元会发射一个输出脉冲,即动作电位。这个电位会传递到下游神经元,而膜电位随即清零。发射动作电位之后,神经元进入不应期,不会对任何输入脉冲产生反应。

HH模型可以是点神经元模型,也可以成为多隔室的神经元模型。HH模型能够精确地重现神经生理学实验中观察到的数据。然而,HH模型会耗费大量算力,即使在配置了超级电脑的蓝脑计划(Blue Brain Project)中,它的模拟速度也仅是实时的数百分之一。

Leaky Integrate-and-Fire Model

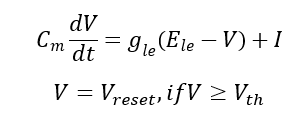

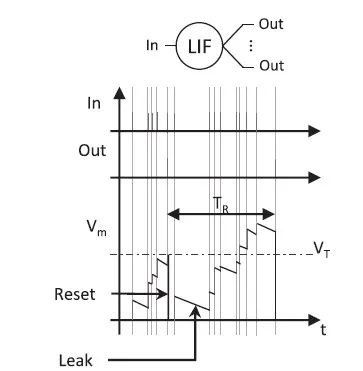

LIF模型最早由法国神经系统科学家Louis Lapicque在1907年提出。LIF模型有几种变体,最简单、使用最广泛的一种是基于电流的LIF模型,它有着比HH模型更高的计算效率和更低的生物准确性。LIF神经元的膜电势计算公式为

图5 LIF模型神经元膜电势的时间演化

a)

b)

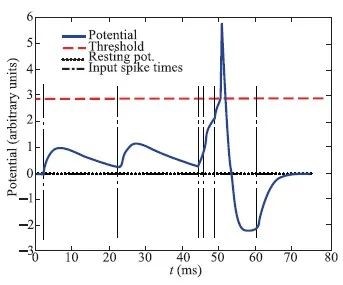

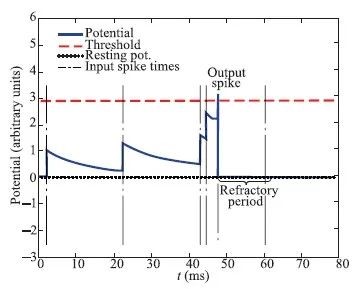

图6 a) HH模型输入脉冲膜电势变化

b) LIF模型中输入脉冲膜电势变化[11]

![]()

Izhikevich Model

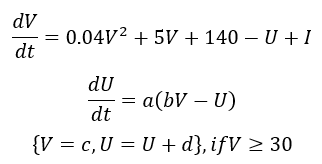

由俄罗斯数学家Eugene M. Izhikeich提出的Izhikevich模型[12],就生物准确性而言接近HH模型,而从计算成本上更接近LIF模型或AdExIF模型[13]。Izhikevich模型的膜电势计算公式为

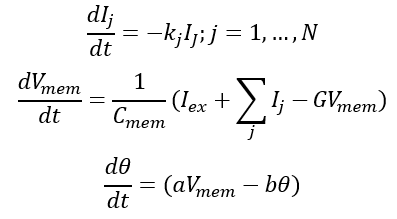

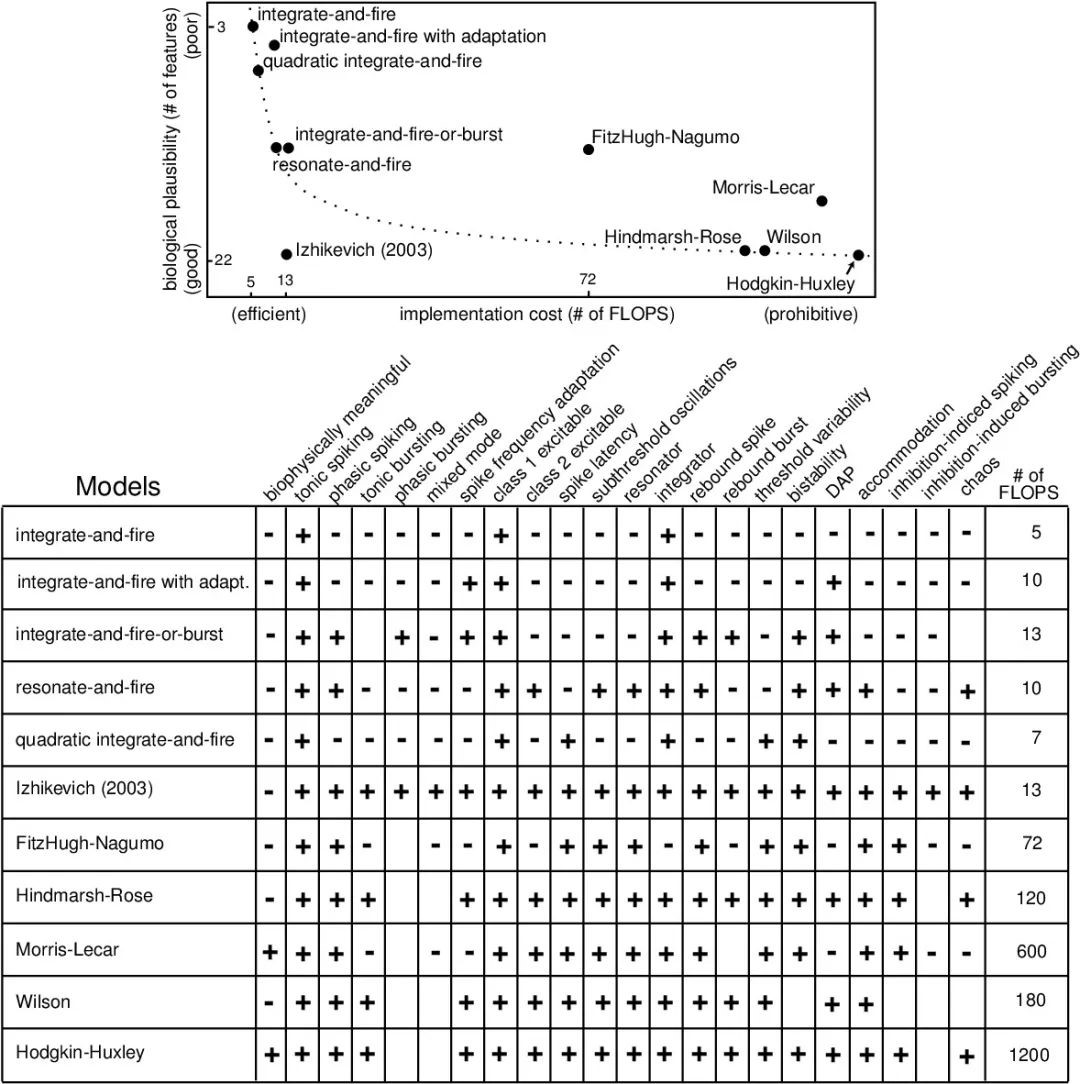

模型的抽象程度应取决于模拟的具体目标,如果目标是为神经系统科学研究提供有效工具,应该选择生物准确性更高的模型,如HH模型。如果为了研发基于SNN的信息处理算法和芯片,简单的模型就能满足需求,复杂模型并不会对提高算法性能有所帮助。

Mihalas-Niebur Model

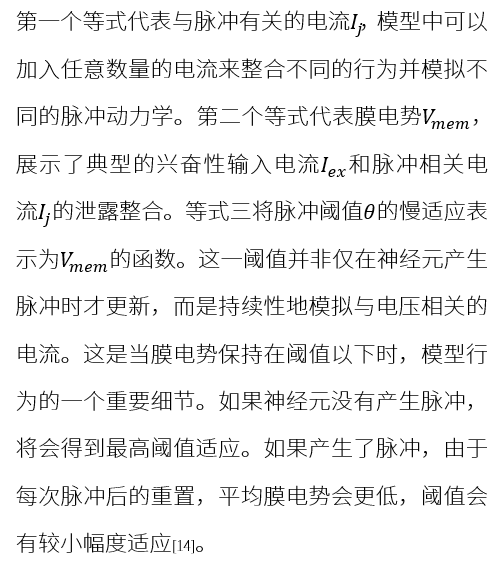

Mihalas-Niebur模型使用简单的一阶微分方程来描述每种状态量,MN模型所有的复杂性都来自脉冲产生后的重置规则。相较于Iz模型,MN模型有以下两个优点:其一,MN模型中所有的状态量都有生物物理学上的解释,让我们能够从模型中预测生物神经元的行为;其二,模块化的MN模型在状态量之间拥有最低程度的干扰,为之后加入随机数量的额外机理和状态量提供了系统性方法。MN模型由下列三个公式描述:

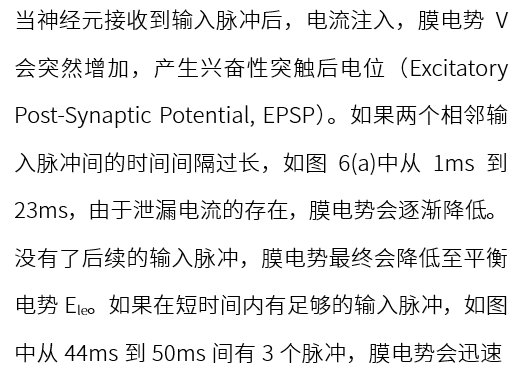

图7 不同脉冲神经元模型抽象度与计算成本的关系[15]

引用Izhikeich的论文《Which Model to Use for Cortical Spiking Neurons?》,各模型在各维度的对比如图7所示。

经典训练算法

脉冲神经网络中可以应用不同的学习规则,如非监督式学习、监督式学习、增强学习、进化算法,以及其他变体等。

非监督式学习

Unsupervised Learning

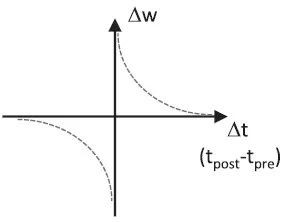

脉冲时间相关的突触可塑性(Spike Time Dependent Plasticity)指如果突触前神经元A总是在突触后神经元B触发前的很短时间内触发,意味着B的触发与A的触发有关,A与B之间的突触强度会增强;反之,如果突触前神经元A总是在突触后神经元B触发后的很短时间内触发,两神经元间的突触强度会减弱。(图 8)

图8 权重∆W与突触前后动作电位相对时间∆t的关系

由于赫布学习理论(Hebb’s Rule)的局部性,采用STDP机制的非监督式学习无法支持多层网络实现高精度,因而衍生出提升STDP训练网络准确性的方法[16]。第一种是在训练中加入监督,即增强学习[17];第二种是对输入数据进行预处理[18];第三种是修改学习规则和各层之间的交流机制[19]。这些方法能够改善分类任务的性能,但仍无法达到SNN训练的监督式学习和ANN训练的反馈式学习的最新水平。

监督式学习

Supervised Learning

Sander M. Bohte和Joost N. Kok提出的SpikeProp算法是一种类似于传统误差反向传播的监督式学习算法,能够克服阈值导致的非连续性问题[20]。Robert Gütig和Haim Sompolinsky提出的Tempotron算法是一种生物学上合理的监督式突触学习算法,能够使神经元有效且广泛地学习决策规则,尤其是当信息是嵌在脉冲模式的时空结构中而非在平均发射速率中时[21]。由Filip Ponulak提出的ReSuMe(Remote Supervised Method)算法结合了赫布理论中的学习窗口和远程监督,其应用领域从运动控制扩展到对各种非静态非线性物体的建模、识别和控制[22]。R˘azvan V. Florian提出的Chronotron算法展示了神经元如何学习产生特定且精确的输出脉冲,因而能够处理和记忆完全时间编码的输出和输入信息[23]。Mohemmed A和Schliebs S提出的SPAN(Spike Pattern Association Neuron)算法能够在监督模式下学习任意脉冲序列之间的关联,从而处理以脉冲的精确时间编码的时空信息。这种算法将学习阶段的脉冲序列转换成模拟信号,以执行常见的数学运算。通过运用著名的Widrow-Hoff规则,还能调整突触权重,从而实现理想的神经元输入/输出脉冲行为[24]。Qiang Yu和Huajin Tang提出的PSD (Precise-Spike-Driven) Synaptic Plasticity算法可以应用于神经元的训练和时空模式分类,将输入的时空脉冲序列与理想的脉冲序列联系起来。PSD算法在生物学上是合理的,并且能执行高效的计算[25]。

这些算法有着不同的工作路线,一些是基于STDP进行的监督式学习,一些计算出网络权重,还有一些算法通过模拟脉冲神经元的行为用误差函数进行梯度计算。SNN的监督式学习,梯度的反向传播,能够使脉冲网络达到与传统神经网络相同的精度。一些模型能够很好地与硬件融合,从而实现低功耗和高精度的推断。

增强学习

Reinforcement Learning

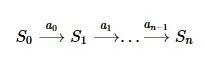

增强学习指通过与环境的互动,基于奖惩机制,选中与良好性能有关的参数,以取得最大化的预期收益。基本要素包括环境(Environment)、主体(Agent)、状态(State)、行动(Action)和收益(Reward)。

增强学习算法主要分为基于值的算法(Value-based)和基于策略的算法(Policy-based)。它的特点之一是试错学习,即一般情况下没有直接的指导信息,主体需要不断与环境交互,通过试错的方式获得最佳策略。另一个特点是延迟回报,原因是增强学习的指导信息少,并在最后一个状态之后才给出。与其他算法相比,增强学习中只有延迟反馈的收益信号而没有监督者,主体的行为会影响以后的所有决策。增强学习是一种序列学习,所有时间维度在增强学习中均有重要意义。它可以抽象为一个序列预测问题,序列中后一个状态只有在前一个行动做出后才能得到,其过程可简单表示为

进化算法

Evolutionary Algorithm

进化算法一般包含基因编码、种群初始化、交叉变异算子、经营保留机制等基本操作。与传统的基于微积分和穷举方法的优化算法相比,进化算法是一种更成熟的、具有高鲁棒性和广泛适用性的全局优化方法。其参数的优化配置基于生物进化原则,如突变、自然选择。进化算法具有自组织、自适应和自学习的特性,能够不受问题性质限制,有效地处理传统优化算法难以解决的复杂问题,经常被用于多目标问题的优化求解中,即进化多目标优化算法(MOEA, Multi-Objective Evolutionary Algorithm)。目前相关算法已被广泛用于参数优化、工业调度、资源分配和复杂网络分析等领域。

John Holland在1960年根据达尔文的进化论提出的遗传算法(GA, Genetic Algorithm)是一种基于自然选择过程的元启发式算法,他的学生David E. Goldberg在1989年对该算法进行了拓展。Pablo Moscato于1989年首次提出文化基因算法(MA, Memetic Algorithm),用局部启发式搜索来模拟大量专业知识支撑的变异过程,是一种基于种群的全局搜索和基于个体的局部启发式搜索的结合体。进化算法在多目标优化问题中的应用最早由David Rosenberg于20世纪60年代初提出,直到80年代中期,多目标优化的进化计算方法逐渐被广泛关注。

与ANN训练算法相比,SNN训练算法还处于未成熟阶段。为避免直接训练SNN,一些研究者选择将传统ANN转化为SNN[26],即首先运用成熟的监督式或非监督式学习算法训练ANN,然后将其转为SNN。另一种避免直接训练的方法是利用Liquid State Machine(LSM)[27]。LSM是一个循环神经网络,神经元间的连接和权重随机生成并保持不变。LSM的学习能力随着其复杂程度增长而增长,因为LSM能够记忆历史信息,所以能处理拥有时间维度的输入,如音频和视频。

上下滑动查看文章参考资料:

[1]

http://news.moore.ren/industry/109738.htm AI从云端走向终端,2025年ASIC市占率将增至48%

[2]

S. Thorpe, D. Fize, and C. Marlot. 1996. Speed of processing in the human visual system. Nature 381, 6582 (1996), 520–522.

[3]

B. Rueckauer and S.-C. Liu. 2018. Conversion of analog to spiking neural networks using sparse temporal coding. In Proceedings of the 2018 IEEE International Symposium on Circuits and Systems (ISCAS’18). 1–5.

[4]

C.-H. Chien, S.-C. Liu, and A. Steimer. 2018. A neuromorphic VLSI circuit for spike-based random sampling. IEEE Transactions on Emerging Topics in Computing 6, 1 (2018), 135–144.

[5]

A. L. Fairhall, G. D. Lewen, W. Bialek, and R. R. de Ruyter van Steveninck. 2001. Efficiency and ambiguity in an adaptive neural code. Nature 412, 6849 (2001), 787–792.

[6]

https://towardsdatascience.com/spiking-neural-networks-the-next-generation-of-machine-learning-84e167f4eb2b Spiking Neural Networks, the Next Generation of Machine Learning by Devin Soni

[7]

https://towardsdatascience.com/spiking-neural-networks-the-next-generation-of-machine-learning-84e167f4eb2b Spiking Neural Networks, the Next Generation of Machine Learning by Devin Soni

[8]

Event-based attention and tracking on neuromorphic hardware by Alpha Renner, Matthew Evanusa and Yulia Sandamirskaya

[9]

Realizing the promise of spiking neuromorphic hardware by Mike Davies

[10]

P. Dayan and L.F. Abbott, Theoretical Neuroscience, MIT Press, Cambridge, MA, USA, 2001.

[11]

T. Masquelier, R. Guyonneau and S.J. Thorpe, “Spike timing dependent plasticity finds the start of repeating patterns in continuous spike trains”, PLoS One, Vol.3, No.1, doi:10.1371/journal.pone.0001377, 2008.

[12]

E.M. Izhikevich, “Which model to use for cortical spiking neurons?”, IEEE Trans. Neural Networks, Vol.15, No.5, pp.1063–1070, 2004.

[13]

R. Brette and W. Gerstner, “Adaptive exponential integrate-and-fire model as an effective description of neuronal activity”, J. Neurophysiol., Vol.94, No.5, pp.3637–3642, 2005.

[14]

Van Schaik, A., Jin, C., McEwan, A., Hamilton, T. J., Mihalas, S., & Niebur, E. (2010). A log-domain implementation of the Mihalas-Niebur neuron model. Proceedings of 2010 IEEE International Symposium on Circuits and Systems. doi:10.1109/iscas.2010.5537563

[15]

Izhikevich, E. M. (2004). Which Model to Use for Cortical Spiking Neurons? IEEE Transactions on Neural Networks, 15(5), 1063–1070. doi:10.1109/tnn.2004.832719

[16]

M. Mozafari, M. Ganjtabesh, A. Nowzari-Dalini, S. J. Thorpe, and T. Masquelier. 2018. Combining STDP and rewardmodulated STDP in deep convolutional spiking neural networks for digit recognition. arXiv:1804.00227.

[17]

R. V. Florian. 2007. Reinforcement learning through modulation of spike-timing-dependent synaptic plasticity. Neural Computation 19, 6 (2007), 1468–1502.

[18]

S. R. Kheradpisheh, M. Ganjtabesh, and T. Masquelier. 2016. Bio-inspired unsupervised learning of visual features leads to robust invariant object recognition. Neurocomputing 205 (2016), 382–392.

[19]

Y. Jin and P. Li. 2016. AP-STDP: A novel self-organizing mechanism for efficient reservoir computing. In Proceedings of the 2016 International Joint Conference on Neural Networks (IJCNN’16). 1158–1165.

[20]

https://pdfs.semanticscholar.org/931d/3dc762c8a3d903782621e339e4dbd35a6ea0.pdf?_ga=2.175711970.1507146399.1571190985-2134275171.1563777804 SpikeProp: Backpropagation for Networks of Spiking Neurons by Sander M. Bohte, Joost N. Kok and Han La Poutr’e

[21]

https://www.nature.com/articles/nn1643 The tempotron: a neuron that learns spike timing-based decisions by Robert Gütig and Haim Sompolinsky

[22]

http://d1.cie.put.poznan.pl/pracownicy/prac_15/Publikacje/ReSuMe_FP_TechRep_2005a.pdf ReSuMe-New Supervised Learning Method for Spiking Neural Networks by Filip Ponulak

[23]

https://coneural.org/florian/papers/2011_chronotron.pdf The Chronotron: A Neuron that Learns to Fire Temporally Precise Spike Patterns by R˘azvan V. Florian

[24]

https://www.ncbi.nlm.nih.gov/pubmed/22830962 Span: spike pattern association neuron for learning spatio-temporal spike patterns by Mohemmed A, Schliebs S, Matsuda S and Kasabov. N

[25]

https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0078318 Precise-Spike-Driven Synaptic Plasticity: Learning Hetero-Association of Spatiotemporal Spike Patterns by Qiang Yu, Huajin Tang, Kay Chen Tan and Haizhou Li

[26]

Y. Jin and P. Li. 2016. AP-STDP: A novel self-organizing mechanism for efficient reservoir computing. In Proceedings of the 2016 International Joint Conference on Neural Networks (IJCNN’16). 1158–1165.

[27]

W. Maass, T. Natschl¨ager and H. Markram, “Real-time computing without stable states: A new framework for neural computation based on perturbations”, Neural Comput., Vol.14, No.11, pp.2531–2560, 2002.

声明:本文章发布目的在于传递更多信息,并不代表本公众号赞同其观点和对其真实性负责。如涉及作品内容、版权和其它问题,请及时与我司联系,我们将在第一时间处理!

作 者 介 绍

/程 韫 韵 Emily/

新氦类脑智能战略总监,复旦-麻省理工学院国际工商管理硕士,拥有多年跨区域、跨行业的企业战略咨询经验。在类脑智能、人工智能技术及应用落地方向有深入的行业分析和市场洞察,为政府、企业提供数智化转型咨询服务,为AI创业团队提供商业落地建议。主导撰写AI技术白皮书,类脑芯片白皮书。

沪公网安备 31011002003093号

沪公网安备 31011002003093号